Что и как закрывать от индексации на сайте интернет-магазина?

Как страницы сайта появляются в поисковой выдаче, всем понятно. Поисковый робот гуляет по страницам и добавляет их в индекс. Чем больше страниц в индексе, тем лучше. Но на сайте интернет-магазина есть много страниц и даже разделов, которые не должны проходить в индексацию – иначе это приведет к пессимизации вашего интернет-магазина в выдаче. В этой статье Labrika.ru напоминает, что нужно закрыть от индексации на сайте интернет-магазина, зачем и как это сделать.

Что закрывать от индексации?

На сайте интернет-магазина обычно закрывают административные данные, страницы с личными данными пользователей, дублирующийся контент, облако тегов, страницы оформления заказа, корзину, RSS, результаты поиска и т.д.

Зачем скрывать страницы от индексации?

Административные данные – это страница входа в административную панель. Она подразумевает только служебное использование, поисковой системе эти данные не важны.

Личные данные пользователей. Логично, что доверяя вам свои персональные данные, пользователь не хочет их распространения и появления в выдаче. Особенно если это не просто имя и фамилия, а например, номер кредитной карты.

Дублирующийся контент. Это настоящий бич интернет-магазинов. Даже частичное дублирование может сильно пессимизировать ваш сайт в выдаче. В интернет-магазинах эта проблема стоит особенно остро.

Самые распространенные виды дублирующегося контента

1. Страницы сортировки и выдачи по поиску. У вас неизбежно есть на сайте поиск, фильтры товаров по цене, компании -производителю, и т.д. И каждая страница с выдачей по поиску или сортировкой по фильтру является дублем. Как правило, такие страницы полностью дублируют заголовок страницы и контент, изменяется только адрес страницы (URL). Поэтому их надо закрывать от индексации.

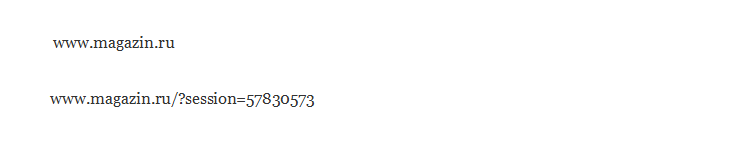

2. Дубли страниц с session ID. Часто интернет-магазины отслеживают посетителей, присваивая каждому из них session ID – уникальные параметры URL-адреса. В итоге, когда пользователь дает кому-то ссылку на страницы сайта с session ID в URL-адресах, эти дубли страниц попадают в индекс поисковых систем.

Пример

Из-за session ID попасть в индекс могут сотни дублирующихся страниц. Лучший способ избежать этого — использовать для идентификации клиентов cookie, а не session ID в адресах страниц. Также рекомендуется прописать тег canonical для каждой страницы.

3. Безопасные страницы на https. У интернет-магазина очень часто, к примеру, корзина работает на безопасном протоколе https. Если при этом в навигационном меню ссылки сделаны не абсолютные (с указанием полного адреса: http://magazin.ru/categorya/towar), а относительные (без указания полного адреса, /categorya/towar), тогда из корзины навигационные ссылки будут вести не на обычные, а на безопасные версии страниц, т. е. на https://magazin.ru/categorya/towar. В итоге поисковый робот перейдет по ним и проиндексирует дубли страниц.

В идеале, эту проблему надо решать заранее, еще только проектируя архитектуру сайта. Но если такой возможности нет, и "что имеем, то имеем", то надо прописать 301 редирект с безопасных страниц на обычные.

4. Облако тегов. Очень удобная система поиска для пользователей. Но от поисковой системы такие вещи лучше скрывать. Причина та же – неуникальность контента (дубли).

5. Страницы оформления заказа и корзина. Эти страницы полезны только для пользователей. Поисковым системам незачем обращать на них внимание. Никакой полезной и важной информации данные страницы не содержат.

6. RSS. Полезная вещь для сайта, но для поискового робота это еще один дубликат. Поэтому лучше закрыть от индексации, по крайней мере, Яндексом.

Как скрыть данные от индексации?

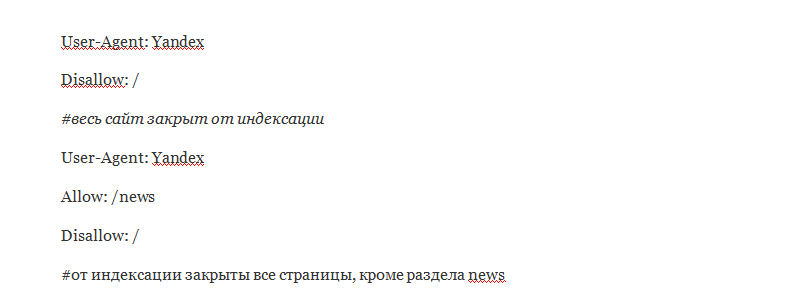

Самый простой способ – использование файла robots.txt. Файл Robots.txt – располагается в корневой папке сайта (например, site.ru/robots.txt).

В нем есть множество директив, но касательно индексации можно выделить две: Disallow (запрещающая) и Allow (разрешающая).

Стандартный код с использованием директив Allow и Disallow

Чтобы закрыть индексацию для Google, нужно в начале прописать: User-Agent: Googlebot.

А чтобы учесть обоих поисковых роботов, нужно прописать в коде так:

User-Agent: *

Disallow: /

Использовать этот файл нужно аккуратно, потому что можно случайно закрыть важные страницы. При указании целой папки в директиве Disallow, нужно быть на 100% уверенным, что в этой папке нет ничего полезного.

Хотелось бы заметить, что файл robots.txt воспринимается Яндексом и Google по-разному. Если закрыть страницы для Яндекса, он не будет обращать на них внимание. А вот для Google robots.txt – это всего лишь рекомендация. То есть никаких гарантий, что страница не попадет в индекс, нет.

Перекладывать всю работу на robots.txt тоже не стоит. Возможны случаи, когда файл окажется недоступным по каким-либо техническим причинам. Тогда, все скрытое станет явным, а это может обернуться настоящим seo-кошмаром.

Зачем тогда нужен файл robots.txt и как по-другому можно закрыть страницы?

В robots.txt можно закрыть доступ ко всему сайту на время внесения изменений, коррективов или переработки страниц. Это необходимо, чтобы поисковая система не вносила недоработанные страницы в индекс.

Страницы с личными данными пользователей, формы регистрации, сортировки и поиска можно закрывать и в robots.txt. Но лучше запретить индексацию этих страниц на уровне CMS. Так будет надежнее.

Административные данные лучше всего также скрывать с помощью специальных плагинов CMS. Файл robots.txt не обеспечивает защиту в этом случае, и при желании хакер может взломать вход в вашу административную панель.

Для дублирующихся страниц можно настроить 301 редирект или воспользоваться тегом rel=canonical – именно в этом его прямое назначение

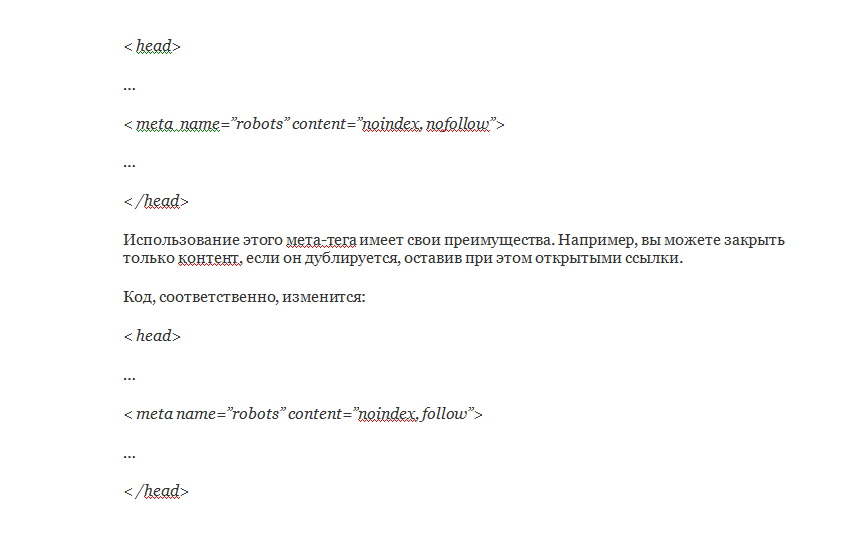

Также для запрета на индексацию можно использовать мета-тег robots. Он имеет 4 параметра: Index-Noindex и Follow-Nofollow.

Чтобы закрыть страницу от индексации, необходимо указать:

По поводу закрытия RSS-ленты сложно дать однозначный совет. При продвижении в Яндексе, лучше всего убрать эту информацию из индекса. А Google воспринимает RSS более адекватно, и появление ленты в индексе, скорее всего, не навредит.

Просто загвоздка какая-то!

Нет никакой загвоздки. Ты продаешь хорошо только когда есть органический трафик. Органический трафик есть только когда твой магазин заметен и интересен. Твой магазин заметен и интересен когда тебе есть РЕАЛЬНО что предложить покупателю. Во всех остальных случаях - ты продаешь хреново. Свернуть